Auszeichnung für KI-Experten

17.09.2024Bei einer wichtigen Konferenz zum Thema Maschinelles Lernen erhielt ein Team um JMU-Professor Damien Garreau einen Best Paper Award. Die Veröffentlichung befasst sich mit den Limitationen von Methoden der KI-Interpretierbarkeit.

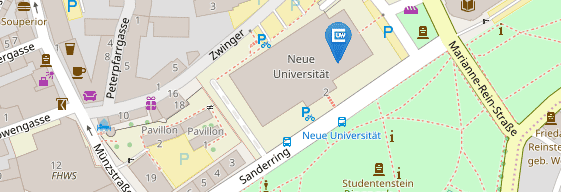

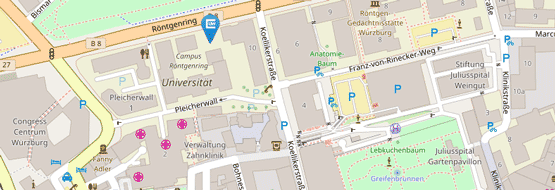

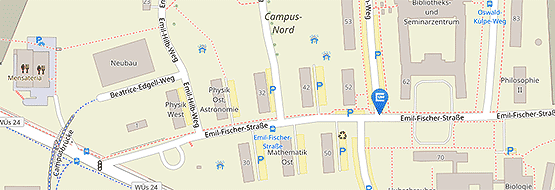

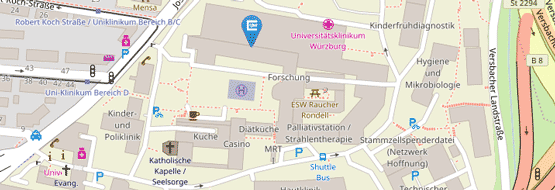

Damien Garreau und sein Forschungsassistent Magamed Taimeskhanov verfassten die Arbeit gemeinsam mit Ronan Sicre von der Ecole Centrale Marseille. Garreau fungiert an der Julius-Maximilians-Universität Würzburg als Professor für die Theorie des Maschinellen Lernens. Außerdem ist er Mitglied des Center for Artificial Intelligence and Data Science (CAIDAS).

In ihrer Veröffentlichung „CAM-based methods can see through walls“ (CAM-basierte Methoden können durch Wände hindurchsehen) befassen sich die Forscher mit den Einschränkungen CAM-basierter Methoden bei der KI-Interpretierbarkeit. Die Auszeichnung erhielten sie im Rahmen der European Conference on Machine Learning (ECML) im litauischen Vilnius.

KI interpretiert Bilder

Das Paper hebt ein wichtiges Problem der häufig verwendeten CAM-Methoden (Class Activation Map) hervor und zeigt, dass diese Bereichen eines Bildes fälschlicherweise Bedeutung zuschreiben können, die das Modell bei seiner Entscheidungsfindung nicht tatsächlich verwendet. Die Forschung liefert sowohl theoretische als auch experimentelle Erkenntnisse und fordert eine sorgfältigere Bewertung von Interpretationswerkzeugen im maschinellen Lernen.

CAM-Methoden kommen zum Einsatz, wenn KI-Modelle Bilder interpretieren sollen. Ein neuronales Netzwerk wird etwa mit tausenden Röntgenbildern trainiert, um Tumore zu erkennen. Nach der Erkennung eines Tumors in einem neuen Röntgenbild kann die CAM-Methode genutzt werden, um die genauen Bereiche des Bildes zu markieren, die das Modell dazu veranlasst haben, diese Entscheidung zu treffen.

Erfolgsgeschichte CAIDAS

Damien Garreau ist seit April 2024 Mitglied von CAIDAS und leitet die Gruppe für Theorie des maschinellen Lernens. Magamed Taimeskhanov, der im September 2024 zu Garreaus Gruppe stieß, ist ebenfalls auf dem Gebiet der erklärbaren KI tätig. Ihre Zusammenarbeit mit Ronan Sicre führte zu diesem bemerkenswerten Erfolg, der die wachsenden Beiträge der CAIDAS-Forschenden zur KI-Gemeinschaft verdeutlicht.

Der Best Paper Award spiegelt die Relevanz und Qualität ihrer Arbeit wider, die sich mit kritischen Fragen zur Interpretierbarkeit von KI beschäftigt. Das CAIDAS-Team beglückwünscht die Autoren zu diesem Erfolg und freut sich auf ihre weiteren Beiträge zu diesem Thema.

Zusammenfassung der Veröffentlichung

Deep-Learning-Algorithmen sind in praktisch allen Anwendungen allgegenwärtig, aber ihr Verhalten kann schwer zu verstehen sein. An dieser Stelle kommt Explainable AI ins Spiel, indem es wichtige Erkenntnisse darüber liefert, wie eine bestimmte Entscheidung getroffen wird.

Im Zusammenhang mit der Bildklassifizierung ist es eine gängige Methode, dem Benutzer eine sogenannte Saliency Map zur Verfügung zu stellen, also eine Heatmap, die hervorhebt, was das Modell im Bild am häufigsten verwendet hat. Wenn das zugrundeliegende Modell ein Convolutional Neural Network ist (CNN, eine Art neuronales Netzwerk, das üblicherweise für Bilder verwendet wird), werden üblicherweise Varianten von CAM verwendet, um diese Karten zu erstellen.

„In unserer Arbeit zeigen wir ein problematisches Verhalten auf, das fast allen diesen Methoden gemeinsam ist: Sie können nachweislich ungenutzte Teile des Bildes hervorheben“, erklärt Damien Garreau. Dies stellt ein Problem dar, da der Endbenutzer zu der Annahme verleitet werden kann, dass Teile des Bildes für die Vorhersage wichtig sind, obwohl sie es nicht sind.

Um dieses Phänomen zu erklären, gingen die Forscher die Problematik von zwei Seiten an. „Erstens führen wir eine theoretische Analyse mit einem einfachen CNN bei der Initialisierung durch und beweisen eine untere Schranke für die Saliency Map“, so Garreau weiter.

Außerdem erstellten sie zwei neue Datensätze, die aus Bildern mit zwei übereinander liegenden Tieren bestehen. „Wir haben ein teilweise blindes VGG16 auf ImageNet trainiert. Genauer gesagt, kann dieses Netzwerk die unteren 25 Prozent des Bildes nicht sehen. In den beiden oben genannten Datensätzen heben CAM-basierte Methoden systematisch den unteren Teil des Bildes hervor, obwohl das teilweise blinde Netzwerk dafür unempfindlich ist.“

Zusammenfassend lasse sich sagen, dass man Saliency Maps nicht für bare Münze nehmen sollte. Die Forscher hoffen, dass der von ihnen vorgeschlagene experimentelle Rahmen in Zukunft zu einer Standardüberprüfung der Karten wird.

Kontakt

Prof. Dr. Damien Garreau, Theorie des Maschinellen Lernens, damien.garreau@uni-wuerzburg.de