Maschinelles Lernen: Geometrie sorgt für verlässlichere Ergebnisse

02.08.2024Neuronale Netze sind durch Angriffe von außen leicht aus dem Konzept zu bringen. Wissenschaftler der Universität Würzburg und der TU München entwickeln jetzt neue Methoden, um diese Systeme robuster zu machen.

Autos, die sich selbständig durch den Verkehr bewegen; Software, die auf Röntgenbildern bösartige Veränderungen in der Lunge erkennt; Chat-Roboter, die anspruchsvolle Aufnahmeprüfungen US-amerikanischer Universitäten bestehen: In den vergangenen Jahren haben zahlreiche Anwendungen, die auf den Prinzipien des „maschinellen Lernens“ basieren, ihren Weg in das Alltagsleben vieler Menschen gefunden.

Trotz ihrer großen Erfolge weisen diese Systeme jedoch allzu oft eine markante Schwachstelle auf: Durch gezielte Angriffe lassen sie sich leicht aus dem Konzept bringen. Wenn ChatGPT dann eine falsche Antwort liefert, ist das im Zweifelsfall nur peinlich für denjenigen, der diesen Fehler nicht bemerkt. Schlimmer sind die Konsequenzen, wenn der autonom fahrende Pkw einen Fußgänger übersieht oder die Klinik-Software einen Tumor als Blutgefäß fehlinterpretiert.

565.000 Euro von der DFG

Wie sich solche Fehler verhindern lassen und wie Deep-Learning-Systeme fit gegen Angriffe von außen gemacht werden können: An diesen Fragen arbeitet ein neuer Forschungsverbund, den die Deutsche Forschungsgemeinschaft (DFG) jetzt genehmigt hat. Dafür verantwortlich sind Leon Bungert, Professor für Mathematik des maschinellen Lernens an der Julius-Maximilians-Universität Würzburg (JMU), und Dr. Leo Schwinn, Postdoc am Lehrstuhl für Data Analytics and Machine Learning an der TU München. Die DFG finanziert das Projekt im Rahmen ihres Schwerpunktprogramms „Theoretische Grundlagen von Deep Learning“ mit insgesamt 565.000 Euro, gut 250.000 Euro davon gehen an die JMU. Die Laufzeit beträgt drei Jahre.

„GeoMAR: Geometric Methods for Adversarial Robustness” lautet der Name des Projekts. Dabei deckt der Begriff der Robustheit – man könnte auch sagen: Verlässlichkeit – zwei unterschiedliche Aspekte ab. „In der Wissenschaft versteht man darunter zum einen die Robustheit der Systeme gegen zufällige Fehler, die beispielsweise eine Folge von Messungenauigkeiten sind“, erklärt Leon Bungert. Gegen solche Fehler seien die heutigen Systeme weitestgehend robust.

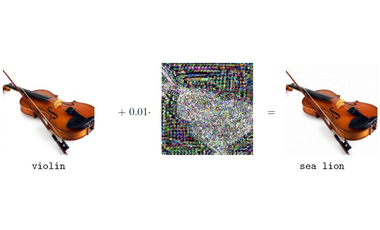

Wenn eine Geige zum Seelöwen wird

Problematischer wird es auf einem anderen Gebiet: der Robustheit gegen feindliche Angriffe. Wenn also Dritte mithilfe von Datenmanipulationen versuchen, die entsprechenden Systeme gezielt „hereinzulegen“, sind sie allzu oft erfolgreich, so der Mathematiker.

Ein anschauliches Beispiel dafür hat Bungert auch zur Hand: Ein ganz normales Foto einer Geige wird von einer entsprechend trainierten Software problemlos als Geige erkannt. Mischt man jedoch unter dieses Bild ein minimales „Rauschen“ – im Prinzip ein paar scheinbar willkürlich angeordnete graue Pixel –, ist das für das menschliche Auge nicht erkennbar. Es sieht immer noch eine gewöhnliche Geige. Für die Software handelt es sich jedoch plötzlich um einen Seelöwen.

Was sich lustig anhört, kann in der Praxis fatale Folgen haben, beispielsweise, wenn ein Aufkleber auf einem Straßenschild oder ein T-Shirt mit einem bestimmten Aufdruck die Systeme autonomer Fahrzeuge so verwirrt, dass sie sich auf einer Kreuzung nicht mehr zurechtfinden. Aus Sicht der Wissenschaft stellen sich deshalb vor allem zwei Fragen: Warum sind neuronale Netze für solche Manipulationen so anfällig? Und was kann man dagegen tun? Antworten auf diese Fragen wollen Bungert und Schwinn in den kommenden Jahren liefern.

Neuronale Netze auf die harte Realität vorbereiten

Ihr Ansatz dabei: „Wir wollen neuronale Netze bereits beim Training mit fehlerhaften Daten füttern, um sie damit quasi auf die ‚harte Realität‘ vorzubereiten“, sagt Bungert. Tatsächlich habe sich gezeigt, dass auf diese Weise Systeme deutlich robuster werden. Gleichzeitig verlieren diese damit jedoch auch an Genauigkeit. Ziel ist es deshalb, mit neuartigen mathematischen Methoden diejenigen neuronalen Netze zu isolieren, die am besten mit solch einem Training klarkommen und nur in einem geringen Maß an Genauigkeit verlieren.

Zum anderen suchen die Wissenschaftler nach der besten Methode, um fehlerhafte Daten zu erzeugen. Diese soll nicht nur für bessere Ergebnisse sorgen, sondern gleichzeitig auch noch möglichst rechnereffizient sein. Schließlich sei das Training neuronaler Netze für den Einsatz im Alltag momentan äußerst zeitintensiv und teuer.

Dafür wählen Bungert und Schwinn einen Ansatz, der sich zunächst nach mehr Aufwand anhört: Sie trainieren nicht ein Netzwerk, sondern gleich zwei. Der Trick dabei: „Das zweite Netzwerk modelliert in diesem Fall einen potenziellen Angreifer“, so Leon Bungert. Nach Ansicht der Wissenschaftler ist das Netzwerk dabei einem Menschen gegenüber deutlich im Vorteil: „Menschen haben in der Regel nur eine begrenzte Anzahl von Ideen“, sagt der Mathematiker. Er hofft, dass das Netzwerk ganz von allein einfallsreicher wird als der Mensch.

Am Ende soll das Ergebnis im Idealfall „das Beste aus zwei Welten“ liefern: Eine deutlich höhere Robustheit gegenüber Angriffen, die aus einer Geige einen Seelöwen machen, und eine zufriedenstellende Genauigkeit auf ungestörten Daten.

Mit geometrischen Methoden die Entscheidungsgrenze ziehen

Bleibt nur noch die Frage, an welcher Stelle in diesem Projekt geometrische Methoden ins Spiel kommen, wie dies ja dessen Name behauptet. Die Antwort ist simpel: „Wenn beispielsweise ein System Bilder dahingehend klassifizieren soll, ob darauf ein Hund oder eine Katze zu sehen ist, muss das Netzwerk eine Entscheidungsgrenze ziehen“, erklärt Leon Bungert. Liegt ein Bild mehrheitlich auf der Seite „Hund“, trifft das Netzwerk diese Entscheidung. Üblicherweise ist diese Entscheidungsgrenze auch genau der Bereich, an dem feindliche Attacken ansetzen.

Mathematisch gesprochen definiert diese Grenze eine Menge. Diese kann mal größer, mal kleiner sein. Mal weist sie klare Kanten, mal unruhige Umrisse auf. Und damit wird sie ein typischer Fall für geometrische Methoden. Tatsächlich gibt es bereits die entsprechenden Vorlagen in der Natur: „Wenn sich ein Ölfilm auf Wasser verteilt, sehen wir im Prinzip auch eine Entscheidungsgrenze, dort, wo die beiden Flüssigkeiten aneinanderstoßen“, sagt Bungert.

Mathematische Modelle, mit denen sich die Ausbreitung von Öl auf Wasser berechnen lassen, gibt es bereits. Bungert und Schwinn wollen sie nun auch auf neuronale Netze ausweiten.

Kontakt

Prof. Dr. Leon Bungert, Professur für Mathematik III (Mathematik des Maschinellen Lernens), Tel: +49 931 31-82849, E-Mail: leon.bungert@uni-wuerzburg.de