Innovative Algorithmen für eine nachhaltige und flexible KI

11/26/2024Die Entwicklung und der Einsatz künstlicher Intelligenz verschlingen jede Menge Ressourcen. Das neue BMBF-geförderte Forschungsprojekt COMFORT will das ändern. Verantwortlich dafür ist der Würzburger Mathematiker Leon Bungert.

Keine Frage: Das Training von KI-Modellen und deren Betrieb in riesigen Rechenzentren kosten gewaltige Mengen an Geld und Energie. Rund sieben Milliarden Dollar soll beispielsweise der ChatGPT-Entwickler OpenAI nach Angaben des Handelsblatts im Jahr 2024 für das Training seiner Modelle ausgeben.

Aktuellen Berechnungen nach soll ChatGPT außerdem allein für das Beantworten von Fragen mindestens 227 Millionen Kilowattstunden Strom pro Jahr verbrauchen. Damit könnten rund 21.600 durchschnittliche US-Haushalte ein Jahr lang versorgt oder mehr als drei Millionen Elektroautos vollständig aufgeladen werden.

Mehr Flexibilität mit kleineren Modellen

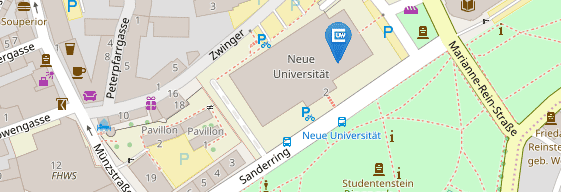

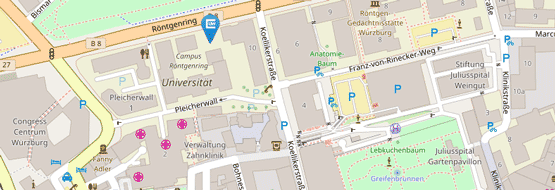

„Geht’s vielleicht auch eine Nummer kleiner“, ist eine Frage, die sich angesichts dieser Zahlen beinahe automatisch aufdrängt. „Ja, das sollte möglich sein“, lautet die Antwort von Leon Bungert. Bungert ist seit gut einem Jahr Professor für Mathematik des maschinellen Lernens an der Julius-Maximilians-Universität Würzburg (JMU). In einem neuen Forschungsprojekt arbeitet er mit Partnern an fünf weiteren Institutionen an flexiblen, resilienten und effizienten Machine-Learning-Modellen, die deutlich kleiner dimensioniert sind.

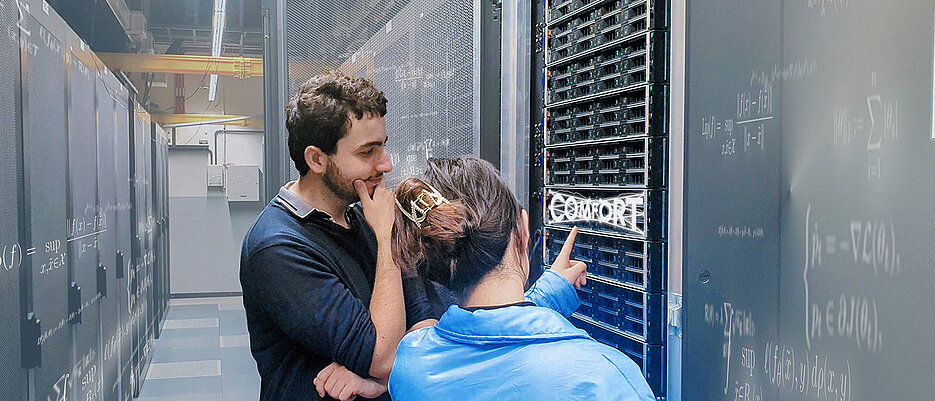

Das Bundesforschungsministerium (BMBF) finanziert das Projekt mit knapp zwei Millionen Euro. Gut 700.000 Euro gehen an die Universität Würzburg. Im Projekt „COMFORT: Komprimierungsmethoden für Robustheit und Transfer“ wollen die Beteiligten innovative Algorithmen zur Modellkompression entwickeln, die den Aufwand für Training und Auswertung von KI-Modellen merklich verringern. Die Laufzeit beträgt drei Jahre.

Raus aus der Abhängigkeit von großen Anbietern

„Aktuell tauchen ständig neue Machine-Learning-Modelle auf, die immer größer und komplexer werden“, beschreibt Leon Bungert den Hintergrund des Forschungsprojekts. Mit den gängigen Rechnern lassen sich solche Datenmengen nicht mehr verarbeiten, weshalb große Firmen mit gewaltigen finanziellen Ressourcen den Markt beherrschen. Kleinere Unternehmen können in diesem Wettlauf nicht mithalten; ihnen droht die Abhängigkeit von Anbietern wie OpenAI, Google oder Microsoft.

Um das zu verhindern, wollen Bungert und die weiteren Beteiligten komprimierte Modelle entwickeln, die deutlich weniger Energie und Ressourcen verbrauchen. „Jede Firma oder Forschergruppe soll damit Modelle für ihre jeweils eigenen Zwecke trainieren können“, beschreibt der Mathematiker als Ziel. Vor allem zwei Methoden sollen dabei helfen, dieses Ziel zu erreichen: Das sogenannte Pruning und die Quantifizierung der Modellparameter.

Den menschlichen Lernprozess imitieren

„Pruning ist ursprünglich ein Begriff aus dem Gartenbau“, erklärt Leon Bungert. Dort bezeichnet er das Zurechtstutzen von Bäumen und Sträuchern. Im Umfeld des maschinellen Lernens wird der Ausdruck für das Vereinfachen von neuronalen Netzen verwendet. In Bungerts Projekt könnte das konkret bedeuten: Alle Parameter, die annähernd oder gleich Null sind, werden nicht berücksichtigt.

Quantifizierung reduziert die Komplexität der Parameter ebenfalls. Beispielsweise, wenn Zahlen nur noch mit maximal einer Nachkommastelle verarbeitet werden anstelle von drei oder vieren. Oder wenn – im Extremfall – in die Berechnungen nur das Vorzeichen einer Zahl einfließt.

Der Nachteil dieser beiden Methoden: „Um ein Modell verkleinern zu können, braucht man zunächst einmal ein großes“, sagt Bungert. Um das zu vermeiden, greift das Projektteam zu einem weiteren Trick: „Wir werden, anders als die großen Entwickler, nicht das größtmögliche neuronale Netzwerk nehmen und mit Daten füllen“, so der Mathematiker. Stattdessen will das Team Modelle von klein nach groß wachsen lassen, bis es die gestellte Aufgabe zuverlässig erfüllt. „Im Prinzip imitieren wir dabei den menschlichen Lernprozess“, sagt Bungert.

In vielen Bereichen einsetzbar

Auf diese Weise hoffen die Projektbeteiligten gleich zwei Fliegen mit einer Klappe zu schlagen. Zum einen besteht die Möglichkeit, dass kleinere Modelle deutlich robuster gegen Störungen sind als ihre großen Vorbilder. Zum zweiten sollen sie über eine Eigenschaft verfügen, an der es Modellen wie ChatGPT mangelt: der Transferbarkeit.

„Unsere Modelle werden nicht ausschließlich eine spezielle Aufgabe erledigen – beispielsweise Bilder erkennen oder Texte produzieren“, sagt Leon Bungert. Stattdessen sollen sie vielseitig einsetzbar sein – ohne zuvor ein spezifisches Training durchlaufen zu müssen. Einsatzmöglichkeiten für solch „kleine Modelle“ gebe es viele – angefangen bei der Spracherkennung über die Analyse beispielsweise von Röntgenbildern bis zur Interpretation von Netzwerkdaten.

Apropos Röntgenbilder: Auch in diesem Fall könnte der Ansatz des Projektteams bereits existierenden überlegen sein. Diese seien nämlich in der Regel auf die Bilder genau eines Herstellers von Röntgenapparaten trainiert. Bekommen sie Aufnahmen eines anderen Herstellers vorgelegt, steigt die Fehlerrate deutlich an. Im Unterschied dazu verspricht Bungert eine „Generalisierbarkeit innerhalb eines Anwendungsgebiets“.

Das Forschungsprojekt

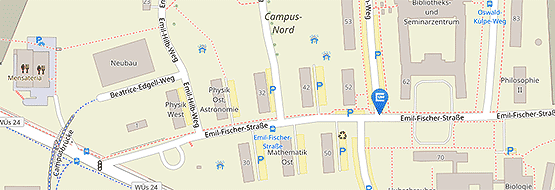

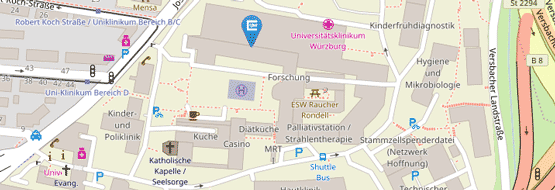

Neben Bungerts Arbeitsgruppe sind an dem Projekt beteiligt: das Deutsche Elektronen-Synchrotron (DESY), die Technische Universität München, die Universität Hamburg und die Friedrich-Alexander-Universität Erlangen-Nürnberg inklusive der AudioLabs. Als Industriepartner ist mit Pruna AI ein Start-up aus München dabei, das auf nachhaltige KI spezialisiert ist. Eingebunden ist auch das Center for Artificial Intelligence and Data Science (CAIDAS) der Universität Würzburg. Dort sind Leon Bungert und sein Projektpartner Ingo Scholtes als Principal Investigators tätig.

Die Fördermaßnahme ist Teil der Umsetzung der KI-Strategie der Bundesregierung. Gefördert werden insgesamt 15 Vorhaben, welche exzellente Grundlagenforschung in Anwendungen bringen – von Wettermodellen über das Erkennen von ungewöhnlichen Zuständen in der Produktion hin zu verbesserten Bild-und-Sprachmodellen.

Kontakt

Prof. Dr. Leon Bungert, Professur für Mathematik III (Mathematik des Maschinellen Lernens), Tel: +49 931 31-82849, E-Mail: leon.bungert@uni-wuerzburg.de